Graeme Jennings/Washington Examiner via AP

l'inchiesta

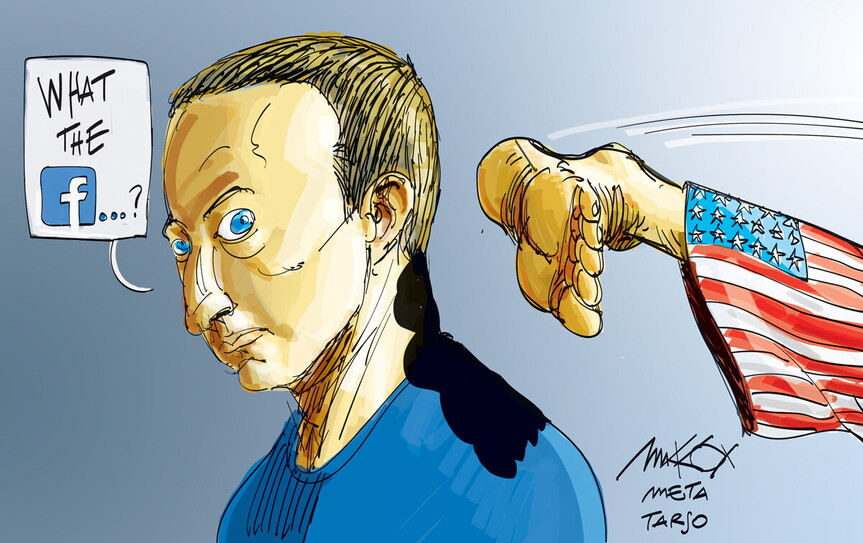

Gli algoritmi di Facebook sono complici del complottismo. Facebook lo sa

“La storia non ci giudicherà con gentilezza”. I documenti interni dell’azienda mostrano come il social network abbia messo in pericolo la democrazia americana. E i suoi stessi dipendenti lo sapevano. La fame di potere sul mercato e la confusione tra libertà di parola e amplificazione algoritmica

Prima di dirvi cosa è successo esattamente alle 14.28 di mercoledì 6 gennaio 2021 alla Casa Bianca – e la reazione molto precisa, a quasi quattromila chilometri di distanza, a Menlo Park, in California – è necessario ricordare il caos di quel giorno, l’esuberanza della folla che è diventata violenza, e come cose diverse sembrassero accadere tutte insieme. Alle 14.10, un microfono acceso ha catturato la voce di un assistente del Senato in preda al panico: “I manifestanti sono nell’edificio”, ed è cominciata l’evacuazione di entrambe le camere del Congresso. Alle 14.13, il vicepresidente Mike Pence è stato portato fuori dall’aula del Senato e dalla Camera. Alle 14.15 si sono sentiti dei cori fragorosi: “Impiccate Mike Pence! Impiccate Mike Pence!”. Alla Casa Bianca, il presidente Donald Trump guardava l’insurrezione in diretta tv. Lo spettacolo lo eccitava. Ciò ci porta alle 14.28, il momento in cui Trump ha condiviso con i suoi 35 milioni di follower su Facebook un messaggio che aveva appena twittato: “Mike Pence non ha avuto il coraggio di fare ciò che avrebbe dovuto per proteggere il nostro paese e la nostra Costituzione… Gli Stati Uniti chiedono la verità!”.

Persino per gli americani abituati agli sfoghi del presidente, l’attacco di Trump al suo stesso vicepresidente – in un momento in cui Pence era braccato dalla folla che Trump aveva mandato al Campidoglio – apparve come una cosa completamente diversa. I dipendenti di Facebook, inorriditi, si affrettarono a mettere in atto misure di emergenza, misure da adottare perché la piattaforma non venisse utilizzata ulteriormente per incitare alla violenza. Quella sera, Mark Zuckerberg, fondatore e ceo di Facebook, pubblicò un messaggio sulla chat interna di Facebook, chiamata Workplace, sotto il titolo “Employee FYI”.

“Questo è un momento buio per la storia della nostra nazione”, ha scritto Zuckerberg, “e so che molti di voi sono spaventati e preoccupati per quello che sta accadendo a Washington. Sono personalmente rattristato da questa violenza di massa”.

I dipendenti di Facebook però non erano tristi. Erano arrabbiati, ed erano molto arrabbiati soprattutto con Facebook. Il loro messaggio era chiaro: questa è colpa nostra. Il Chief Technology Officer Mike Schroepfer chiese ai dipendenti di “tenere duro” mentre l’azienda organizzava una risposta. “Abbiamo tenuto duro per anni”, disse una persona. “Dobbiamo esigere più azione dai nostri capi. A questo punto, la sola fiducia non è sufficiente”.

“Con tutto il rispetto, davvero non abbiamo avuto abbastanza tempo per capire come gestire tutto questo senza contribuire alla violenza?”, rispose un altro membro dello staff. “Abbiamo alimentato questo fuoco per molto tempo e ora non dovremmo essere sorpresi che sia fuori controllo”. “Sono stanco di luoghi comuni; voglio azioni concrete”, scrisse un altro membro dello staff. “Non siamo un’entità neutrale”. “Uno dei giorni più bui nella storia della democrazia e dell’autogoverno”, scrisse ancora un altro membro. “La storia non ci giudicherà con gentilezza”.

L’Atlantic ha avuto modo di esaminare migliaia di pagine di documenti di Facebook, tra cui conversazioni interne e ricerche condotte dalla società, dal 2017 al 2021. Frances Haugen, la whistleblower ed ex ingegnere di Facebook che ha testimoniato davanti al Congresso all’inizio di ottobre, ha presentato prima della sua testimonianza una serie di rivelazioni alla Sec (la versione americana della Consob) e al Congresso. Versioni ridotte di questi documenti sono state ottenute da un consorzio di più di una dozzina di agenzie stampa, tra cui l’Atlantic. I nomi dei dipendenti di Facebook sono per lo più oscurati. I documenti sono sorprendenti per due motivi: primo, perché il loro volume è incredibile. Secondo, perché questi documenti lasciano poco spazio ai dubbi sul ruolo cruciale di Facebook nel promuovere la causa dell’autoritarismo in America e nel mondo.

L’autoritarismo precede l’ascesa di Facebook, naturalmente. Ma Facebook rende molto più facile per i leader autoritari vincere. I documenti di Facebook mostrano che i dipendenti hanno più volte lanciato allarmi sui pericoli posti dalla piattaforma: come Facebook amplifica l’estremismo e la disinformazione, come incita alla violenza, come incoraggia la radicalizzazione e la polarizzazione politica. E più volte i membri dello staff fanno i conti con i modi in cui le decisioni di Facebook alimentano questi danni, e supplicano il management di fare di più. E più volte, dicono i dipendenti, i capi di Facebook li ignorano. Al tramonto del 6 gennaio 2021, l’assedio era stato spezzato, anche se non senza vittime. Il sindaco di Washington aveva emesso un coprifuoco in tutta la città e la Guardia nazionale pattugliava le strade. Facebook annunciò che avrebbe bloccato l’account di Trump, impedendogli di fatto di postare sulla piattaforma per 24 ore.

“Pensate davvero che 24 ore siano un divieto significativo?”, scrisse un dipendente di Facebook su una bacheca interna, per poi riferirsi, proprio come altri, agli anni di fallimenti e di inazione che avevano preceduto quel giorno. Come ci si aspetta che possiamo ignorare quel che accade quando il management preferisce servire gruppi che incitano la violenza come accaduto oggi invece che ricerche basate sui dati? I dipendenti di ogni settore hanno fatto la loro parte per indicare i cambiamenti e i miglioramenti possibili per la piattaforma, ma sono stati respinti. Potete darci una ragione per cui possiamo aspettarci che questo cambi in futuro”. La domanda era senza punto interrogativo. L’impiegato sembrava già sapere che non ci sarebbe stata una risposta soddisfacente.

Facebook ha poi esteso il ban a Trump almeno fino alla fine del mandato presidenziale, e poi, quando l’Oversight Board ha deciso di non imporre un divieto indefinito, ha esteso il divieto temporaneo fino al 7 gennaio 2023. Ma per alcuni dipendenti di Facebook, questo divieto su Trump arrivava ridicolmente in ritardo. Facebook ha finalmente agito, ma per molti nell’azienda era troppo poco e troppo tardi. Per mesi, Trump aveva incitato l’insurrezione, in bella vista, su Facebook. Facebook ha respinto l’allarmismo dei propri dipendenti in vari modi. Un portavoce mi ha detto che una delle tattiche più intelligenti è stata quella di sostenere che i dipendenti che lanciavano allarmi sui danni fatti dal loro datore di lavoro stavano semplicemente godendo della “cultura molto aperta” di Facebook, in cui le persone sono incoraggiate a condividere le loro opinioni. Questa posizione permette a Facebook di rivendicare trasparenza ignorando la sostanza delle denunce, e quel che le denunce implicano, cioè che molti dipendenti di Facebook sono convinti che la loro azienda operi senza una bussola morale.

“I dipendenti hanno insistito a gran voce per mesi per cominciare a trattare i politici di alto livello nello stesso modo in cui ci trattiamo a vicenda sulla piattaforma”, ha scritto un dipendente nella chat del 6 gennaio. “Questo è tutto ciò che chiediamo... Oggi è stato tentato un colpo di stato contro gli Stati Uniti. Spero che le circostanze, la prossima volta che ci confronteremo, non saranno ancora più tragiche”. Torniamo indietro di due mesi, al 4 novembre 2020, il giorno dopo le elezioni presidenziali. L’esito delle elezioni era ancora sconosciuto quando un attivista politico trentenne creò un gruppo su Facebook chiamato “Stop the Steal”, fermate la ruberia. “I democratici stanno tramando per minare il diritto di voto e annullare i voti dei repubblicani”, si legge nel manifesto del gruppo. “Sta a noi, il popolo americano, combattere e porre fine a tutto questo”. Nel giro di poche ore, “Stop the Steal” prese a crescere a un ritmo sorprendente. A un certo punto aggiungeva 100 nuovi membri ogni 10 secondi. Ben presto diventò uno dei gruppi con un tasso di crescita più veloce nella storia di Facebook. Quando “Stop the Steal” si diffuse, i dipendenti di Facebook iniziarono a scambiarsi messaggi sulla chat interna, esprimendo ansia per il loro ruolo nella diffusione della disinformazione elettorale. “Non solo non facciamo niente per la disinformazione elettorale che si amplifica nei commenti”, un impiegato ha scritto il 5 novembre, “noi li amplifichiamo ancora di più e diamo loro una diffusione più ampia. Perché?”.

A quel punto, meno di 24 ore dopo la creazione del gruppo, “Stop the Steal” era arrivato a 333.000 membri, e l’amministratore del gruppo non riusciva a tenere il passo con il ritmo dei commenti. I dipendenti di Facebook erano preoccupati che i membri di “Stop the Steal” stessero incitando alla violenza, e il gruppo arrivò all’attenzione dei dirigenti. Facebook, a suo merito, prontamente chiuse il gruppo. Ma oggi sappiamo che “Stop the Steal” aveva già raggiunto troppe persone, troppo velocemente, per essere contenuto. Il movimento è quindi saltato da una piattaforma all’altra. E anche quando il gruppo è stato rimosso da Facebook, è rimasto un nucleo cruciale per coordinare l’attacco al Campidoglio. Dopo che il più noto gruppo Facebook “Stop the Steal” è stato smantellato, sono sorti gruppi di imitatori. Per tutto il tempo il movimento è stato incoraggiato dal presidente Trump, che ha postato su Facebook e Twitter – a volte una dozzina di volte al giorno – la sua denuncia, sempre la stessa: lui aveva vinto e Joe Biden aveva perso. Anche la sua richiesta era sempre la stessa: era giunta l’ora che i suoi sostenitori combattessero per lui e per il loro paese.

Mai prima d’ora nella storia del dipartimento di Giustizia un’indagine è stata tanto aggrovigliata con i social media. Facebook è onnipresente nei documenti giudiziari correlati, si intreccia alle storie di come le persone sono state coinvolte nella rivolta, per riapparire poi nel bilancio finale del caos e dello spargimento di sangue. Più di 600 persone sono state accusate di reati in relazione al 6 gennaio. I documenti del tribunale specificano anche come Facebook abbia fornito agli investigatori informazioni identificative sui propri utenti, così come i metadati che gli investigatori hanno utilizzato per confermare la posizione dei presunti colpevoli quel giorno. Presi nel complesso, i documenti giudiziari del 6 gennaio sono essi stessi un feed di Facebook pieno di selfie postati sulle applicazioni di Facebook nel corso dell’insurrezione.

In un freddo e luminoso mercoledì, settimane dopo l’insurrezione, quando finalmente arrivarono al Russell Dean Alford’s Paint & Body Shop a Hokes Bluff, in Alabama, gli agenti dell’Fbi dissero che la reazione di Alford fu questa: “Mi chiedevo quando sareste arrivati. Immagino che abbiate visto i video sulla mia pagina Facebook”. Alford si è dichiarato non colpevole delle quattro accuse federali, tra cui l’ingresso consapevole in un edificio in cui era vietato l’accesso e il comportamento atto a turbare l’ordine pubblico.

Non solo i rivoltosi trasmettevano in live-streaming i loro crimini mentre li commettevano, ma i registri del tribunale federale mostrano che chi è stato incriminato ha passato molte settimane ad alimentare la violenza su Facebook con post come: “NESSUNA SCUSA! NESSUNA RITIRATA! NESSUNA RESA! PRENDETE LE STRADE! RIDATECI IL NOSTRO PAESE! 1/6/2021=7/4/1776” e “Tirate fuori le palle e riprendetevi il vostro governo!”. Quando si mettono insieme le storie che hanno attraversato il periodo tra l’elezione di Joe Biden e il suo insediamento, è facile vedere quanto Facebook sia stato strumentale all’attacco del 6 gennaio (un portavoce mi ha detto che la nozione che Facebook abbia giocato un ruolo strumentale nell’insurrezione è “assurda”).

Considerate, per esempio, il caso di Daniel Paul Gray. Secondo la dichiarazione giurata di un agente dell’Fbi, Gray ha pubblicato diversi post su Facebook nel mese di dicembre a proposito dei suoi piani per il 6 gennaio, commentando un post: “Il 6 una cazzo di fiumana di noi starà andando a Washington per chiudere l’intera città. Sarà pazzesco, non vedo letteralmente l’ora”. In un messaggio privato, si è vantato di essersi appena unito a una milizia e ha anche inviato un messaggio dicendo: “Sarete a Washington il 6 come Trump ci ha chiesto di fare?”. Gray è stato poi incriminato con nove capi d’imputazione, tra cui ostruzione di un procedimento ufficiale, partecipazione ad atti di violenza, ingresso violento, aggressione e ostruzione delle forze dell’ordine. Si è dichiarato non colpevole.

Poi c’è il caso di Cody Page Carter Connell, che avrebbe incoraggiato i suoi amici di Facebook a raggiungerlo a Washington il 6 gennaio. Connell è stato accusato di otto reati federali e si è dichiarato per tutti non colpevole. Dopo l’insurrezione, secondo una dichiarazione giurata dell’Fbi, si è vantato su Facebook di quello che aveva fatto. “Abbiamo spinto i poliziotti contro il muro, hanno lasciato cadere tutta la loro attrezzatura e se ne sono andati”, ha scritto in un messaggio. “Voi tutti ragazzi avete fatto qualcosa di serio, lol”, ha risposto qualcuno. “Sembra già una guerra civile?”. La risposta di Connell: “Ci arriveremo”.

In tutta l’America, la gente ha usato Facebook per organizzare convogli verso Washington, e per riempire gli autobus affittati per il viaggio. Gli utenti di Facebook hanno condiviso e ridiscusso messaggi come questo, che è apparso prima dell’alba della vigilia di Natale in un gruppo Facebook per il “Lebanon Main Truth Seekers”: “Questa elezione è stata rubata e noi siamo stati messi su una strada che porta lentamente verso un dominio cinese da un’istituzione che è traditrice e fin troppo disposta a far credere che il furto sia stato in qualche modo la volontà del popolo. Qualcuno è interessato a livello locale a organizzare una carovana a Washington D.C. per il conteggio dei voti del Collegio elettorale il 6 gennaio 2021? Mi sto organizzando e farò da autista se qualcuno vuole venire in autostop, o da guida per una carovana di veicoli. Se venisse fatta una chiamata per corpi capaci, ci sarebbe una risposta? Buon Natale”. Il post era firmato da Kyle Fitzsimons, poi incriminato con l’accusa di aver attaccato dei poliziotti il 6 gennaio. Fitzsimons si è dichiarato non colpevole di tutte le otto accuse contro di lui.

Forse state pensando: Siamo nel 2021 – sicuramente la gente ha usato Facebook per pianificare l’insurrezione. È ciò che utilizzano per pianificare tutti gli aspetti della loro vita. Ma ciò che emerge da un’attenta lettura dei documenti di Facebook, e dall’osservazione del modo in cui l’azienda connette velocemente grandi gruppi di persone, è che Facebook non è uno strumento passivo, ma un catalizzatore. Se gli organizzatori avessero cercato di pianificare la manifestazione utilizzando altre tecnologie di epoche precedenti, come i telefoni, avrebbero dovuto identificare e raggiungere individualmente ogni potenziale partecipante, quindi convincerli a raggiungere Washington. Facebook ha reso gli sforzi di coordinamento delle persone altamente visibili su scala globale. La piattaforma non solo li ha aiutati a reclutare partecipanti, ma ha offerto alle persone un ulteriore senso di forza nei numeri. Facebook ha dimostrato di essere la perfetta campagna pubblicitaria per i golpisti.

Tra coloro che sono stati accusati di rispondere all’appello di Trump per la rivoluzione c’erano 17 persone da Florida, Ohio, North Carolina, Georgia, Alabama, Texas e Virginia che presumibilmente si sono coordinate su Facebook e altre piattaforme per unire le forze con la milizia di estrema destra conosciuta come gli Oath Keepers. Una di queste persone, Kelly Meggs, 52 anni, della Florida rurale, avrebbe partecipato con sua moglie a un addestramento con armi per prepararsi al 6 gennaio. “Trump ha detto che ci sarà da scatenarsi!!!!!!!”, ha scritto Meggs in un messaggio su Facebook il 22 dicembre, secondo un capo di imputazione. “Ci sarà da scatenarsi!!!!!!! Vuole che CI SCATENIAMO, questo è quello che ci sta dicendo. Ci ha chiamati tutti in Campidoglio e vuole che ci scateniamo!!! Sissignore!!! Signori, stiamo andando a Washington, raccogliete le vostre cose!!”. Meggs e i suoi amici di Facebook sono arrivati a Washington pronti per la battaglia con un equipaggiamento paramilitare, tra cui apparecchiature radio, mimetiche, elmetti, protezioni per gli occhi e giubbotti antiproiettile. Sono accusati di cospirazione contro gli Stati Uniti. Meggs si è dichiarato non colpevole. Sua moglie, Connie Meggs, ha il processo fissato per gennaio 2022.

Anche Ronald Mele, un californiano di 51 anni, ha usato Facebook per condividere i piani per l’insurrezione: ha scritto in un post su Facebook a dicembre che stava facendo un viaggio a Washington “per sostenere il nostro presidente il 6 e i giorni successivi, per ogni evenienza”, secondo l’accusa. I pubblici ministeri affermano che lui e altri cinque uomini hanno usato principalmente Telegram per organizzarsi, discutendo di quali armi da fuoco, proiettili per fucili e altre armi portare con sé e riferendosi a sé stessi come i soldati della “Brigata DC” – e tre di loro hanno postato anche su Instagram e Facebook i loro piani. Il 2 gennaio, quattro membri del gruppo si sono incontrati a casa di Mele a Temecula, a circa un’ora a nord di San Diego. Prima di caricare tutto su un suv e partire, qualcuno ha suggerito di fare una foto di gruppo. Hanno posato insieme, facendo gesti con le mani associati ai “Three Perceters”, un movimento di milizia di estrema destra classificato come organizzazione terroristica in Canada (Mele si è dichiarato non colpevole di tutte e quattro le accuse contro di lui).

Il 6 gennaio, dicono le carte, i membri della Brigata DC erano tra i rivoltosi che hanno sfondato l’ultima linea di polizia, aprendo l’accesso alla terrazza ovest del Campidoglio. Alle 14.30, subito dopo che il presidente Trump aveva incitato i rivoltosi su Facebook, Mele e compagni erano sulla terrazza a festeggiare, a farsi i selfie e a gridare ai compagni di entrare nel palazzo. Uno degli uomini del gruppo, Alan Hostetter, un 56enne di San Clemente, ha postato un selfie sul suo account Instagram, con una folla di rivoltosi sullo sfondo. Hostetter, che si è dichiarato non colpevole, ha aggiunto una didascalia alla foto: “Questo è stato lo sparo sentito in tutto il mondo! … La versione 2021 del 1776. Quella guerra è durata otto anni. Ci stiamo soltanto scaldando”.

Nel novembre del 2019, lo staff di Facebook notò un problema serio. Facebook offre una raccolta di reazioni sotto forma di emoji. Oggi includono “like”, “amore”, “cura”, “haha”, “wow”, “triste” e “arrabbiato”. I ricercatori avevano scoperto che i post dominati da reazioni “arrabbiate” avevano sostanzialmente maggiori probabilità di andare contro gli standard della comunità, compresi i divieti di vari tipi di disinformazione, secondo i documenti interni. Ma Facebook fu lento ad agire. Nel luglio del 2020, i ricercatori presentarono i risultati di una serie di esperimenti. A quel tempo, Facebook stava già dando un peso differente alle reazioni diverse dal “like” nel suo algoritmo, cioè i post che ottenevano una reazione “arrabbiata” avevano maggiori probabilità di essere visualizzati nei feed di notizie degli utenti rispetto ai post che avevano semplicemente ottenuto un “like”. I contenuti che stimolavano la rabbia non si erano diffusi soltanto perché le persone avevano maggiori probabilità di condividere cose che le facevano arrabbiare; l’algoritmo aveva fornito un vantaggio ai contenuti che alimentavano la rabbia. Gli operatori di Integrity di Facebook, i dipendenti incaricati di affrontare problemi come la disinformazione e lo spionaggio sulla piattaforma, conclusero che c’erano buone ragioni di credere che controllare i post che inducevano la rabbia avrebbe aiutato a fermare la diffusione di contenuti dannosi.

Riportando a zero il peso della rabbia nell’algoritmo, i ricercatori scoprirono che potevano impedire che i post ai quali le persone reagivano con rabbia fossero visualizzati da altrettanti utenti. Questo, a sua volta, si traduceva in una significativa riduzione (fino al 5 per cento) di incitamento all’odio, disinformazione, bullismo e post violenti, tutti correlati alla violenza offline, a cui gli utenti erano stati esposti. Facebook implementò la modifica all’inizio del settembre 2020, mostrano i documenti; un portavoce di Facebook ha confermato che il cambiamento è rimasto in vigore. È stata una vera vittoria per i dipendenti del team Integrity.

Ma normalmente non funziona in questo modo. Nell’aprile del 2020, secondo i documenti depositati da Frances Haugen alla Sec, i dipendenti di Facebook avevano raccomandato di modificare l’algoritmo in modo che il feed delle notizie togliesse la priorità ai contenuti per le persone in base al comportamento dei loro amici di Facebook. L’idea era che il feed delle notizie di una persona dovesse essere modellato maggiormente sulle persone e sui gruppi che una persona aveva scelto di seguire. Fino a quel momento, se il tuo amico di Facebook aveva visto una teoria del complotto e aveva reagito, l’algoritmo di Facebook poteva mostrarlo anche a te. L’algoritmo trattava qualsiasi engagement nella tua rete come il segnale che valesse la pena condividere qualcosa. Ma ora alcuni dipendenti di Facebook volevano costruire interruttori automatici per rallentare questa forma di condivisione. Gli esperimenti dimostrarono che questa modifica avrebbe ostacolato la distribuzione di contenuti di odio, polarizzanti e che incitavano alla violenza nei feed di notizie. Ma Zuckerberg “rifiutò questo intervento che avrebbe potuto ridurre il rischio di violenza durante le elezioni del 2020”, afferma un documento depositato. Un report interno che sintetizza il ragionamento di Zuckerberg dice che lui voleva evitare nuove funzionalità che avrebbero intralciato “interazioni sociali significative”. Ma secondo la definizione di Facebook, dicono i suoi dipendenti, l’engagement è considerato “significativo” anche quando genera bullismo, incitamento all’odio e condivisioni di contenuti pericolosi.

Questo episodio, come la risposta di Facebook all’incitamento che proliferò tra le elezioni e il 6 gennaio, riflette un problema fondamentale. La grande dimensione di Facebook consente all’azienda di influenzare il discorso e i modelli di pensiero di miliardi di persone. Quello che il mondo sta vedendo ora, attraverso la finestra fornita da risme di documenti interni, è che Facebook cataloga e studia i danni che infligge alle persone. E poi continua comunque a farli. “Sono preoccupato che il modello di Mark di rispondere a una domanda diversa da quella che è stata posta sia un sintomo di un problema più grande”, ha scritto un dipendente di Facebook in un post interno nel giugno 2020, riferendosi a Zuckerberg. “Spero sinceramente di sbagliarmi, e sono ancora fiducioso. Ma capisco perfettamente anche i miei colleghi che hanno rinunciato e non posso biasimarli di essersene andati. Facebook non è neutrale e nemmeno lavorare qui lo è”. “Vorrei solo che potessimo ascoltare direttamente la verità”, ha aggiunto un altro. “Ogni cosa ci dice che noi (i dipendenti) veniamo ingannati in modo intenzionale”.

Mi occupo di Facebook ormai da un decennio e so che le sfide che deve affrontare sono nuove e complesse. Una delle rivelazioni più importanti e incoraggianti dei Facebook Papers è che molti dipendenti di Facebook stanno cercando di risolvere questi problemi. Uno degli aspetti scoraggianti di questi documenti è che questi stessi dipendenti hanno poca o nessuna fiducia nella dirigenza di Facebook. È impressionante vedere l’enorme numero di dipendenti di Facebook – persone che presumibilmente comprendono la loro azienda come o meglio degli osservatori esterni – che credono che il loro datore di lavoro sia moralmente fallito. Ho parlato con diversi ex dipendenti di Facebook che hanno descritto la cultura aziendale guidata dai dati come estrema, persino per gli standard della Silicon Valley (ho accettato di non nominarli, perché temevano ritorsioni e ostracizzazione da parte di Facebook). I dipendenti di Facebook sono sottoposti a un’enorme pressione per dimostrare quantitativamente i loro contributi individuali agli obiettivi di crescita dell’azienda, mi hanno detto. Nuovi prodotti e funzionalità non vengono approvati a meno che lo staff che li propone non dimostri come porteranno maggiore engagement. Di conseguenza, Facebook ha alimentato una corsa agli armamenti degli algoritmi all’interno dei suoi ranghi, mettendo in competizione i principali team di prodotto e ingegneria, come il team di News Feed, e i loro colleghi dei team di Integrity, che hanno il compito di mitigare i danni. Queste squadre stabiliscono obiettivi che sono spesso in conflitto diretto tra loro.

Uno dei membri dello staff di Integrity di Facebook ha scritto a lungo su questa dinamica in una nota di addio ai colleghi nell’agosto 2020, descrivendo come i rischi per gli utenti di Facebook “si aggravano” a causa dell’onere “asimmetrico” imposto ai dipendenti di “dimostrare legittimità e valore per gli utenti” prima del lancio di qualsiasi tattica di mitigazione del danno, un onere non condiviso da coloro che sviluppano nuove funzionalità o modifiche dell’algoritmo con in mente la crescita e l’engagement. La nota diceva: “Fummo disposti ad agire soltanto dopo che le cose erano precipitate in una situazione terribile... Personalmente, durante il tempo in cui abbiamo esitato, ho visto gente della mia città natale finire sempre più invischiata nel garbuglio di QAnon, No mask, No vax e vari complotti su Facebook. È stato doloroso osservarli”.

I dipendenti di Facebook, anche gli ex, descrivono la stessa cultura dannosa, in cui le misure per rendere Facebook più sicuro vengono annullate dalla dirigenza o non vengono mai approvate (un portavoce di Facebook ha respinto l’idea che la società non dia priorità al benessere dei suoi utenti). Questa cultura dannosa ha prodotto una piattaforma dannosa: un ecosistema algoritmico in cui gli utenti sono spinti verso contenuti sempre più estremi e dove Facebook espone consapevolmente i suoi utenti a teorie del complotto, disinformazione e incitamento alla violenza. Un esempio è un programma che è come una lista di vip su Facebook, che consente ad alcuni degli utenti con maggiori probabilità di diffondere disinformazione di infrangere le regole di Facebook senza subire conseguenze. I documenti interni mostrano che milioni di utenti di alto profilo, inclusi i politici, vengono lasciati stare da Facebook anche quando incitano alla violenza.

Alcuni dipendenti hanno segnalato ai loro superiori quanto questo sia pericoloso, spiegando in un report interno che Facebook aveva solide prove che dimostrano che quando “un contenuto è condiviso da un politico complice, tende a essere percepito come più affidabile, interessante, e utile che se a condividerlo sia un comune cittadino”. In altre parole, inserire nella lista utenti influenti con un seguito massiccio su Facebook non è solo un’applicazione segreta e non controllata delle regole di Facebook; equivale a “proteggere i contenuti che più possono ingannare, e quindi danneggiare, le persone sulle nostre piattaforme”. Molti a Facebook hanno provato a mettere fine al programma, ma non ci sono riusciti. Solo quando la sua esistenza è stata segnalata a settembre dal Wall Street Journal, l’Oversight Board di Facebook ha chiesto alla dirigenza maggiori informazioni sulla pratica. La scorsa settimana, il Board ha rimproverato pubblicamente Facebook per non essere stato “pienamente esplicito” sul programma (sebbene i membri di questo consiglio di sorveglianza siano selezionati da Facebook e pagati da Facebook, l’azienda caratterizza il loro lavoro come indipendente).

I Facebook Papers mostrano che i dipendenti erano tormentati dal dover trovare un compromesso tra fare la cosa giusta per il mondo e fare la cosa giusta per il proprio datore di lavoro. “Sono così combattuto”, ha scritto un dipendente nel dicembre del 2020 in risposta ai commenti di un collega su come combattere l’incitamento all’odio e alla violenza di Trump. “Seguire queste raccomandazioni potrebbe accelerare la nostra stessa fine in moltissimi modi, il che potrebbe interferire con tutto il bene che facciamo nel mondo. Come dare un peso a quest’impatto?”. I messaggi mostrano che i dipendenti desiderano che Facebook faccia scelte dignitose e si preoccupano che la dirigenza non sia in grado di farle. Allo stesso tempo, molti credono chiaramente che Facebook sia, nel complesso, ancora una forza benefica e si preoccupano anche di danneggiare le possibilità di crescita della piattaforma.

Due ex dipendenti che hanno lasciato l’azienda negli ultimi due anni mi hanno detto che queste preoccupazioni ultimamente sono state esacerbate dai timori per un calo dei nuovi post su Facebook. Le persone postano su Facebook nuovo materiale meno frequentemente e i suoi utenti sono in media più anziani di quelli di altre piattaforme social. La popolarità esplosiva di piattaforme come TikTok, soprattutto tra i giovani, ha scosso la dirigenza di Facebook. Tutto ciò fa sì che la piattaforma si basi maggiormente sui modi in cui può manipolare ciò che i suoi utenti vedono per raggiungere i suoi obiettivi. Questo spiega perché Facebook è così dipendente dall’infrastruttura dei gruppi, oltre a rendere le ricondivisioni altamente visibili, per mantenere le persone agganciate. Ma questo approccio pone un grosso problema per la qualità complessiva della piattaforma, e gli ex dipendenti mi hanno ripetutamente detto che i gruppi rappresentano una delle più grandi minacce per gli utenti di Facebook.

In un documento particolarmente affascinante, i lavoratori di Facebook delineano gli aspetti negativi della “community”, una parola d’ordine che Zuckerberg utilizza spesso per giustificare l’esistenza della piattaforma. Zuckerberg ha definito la missione di Facebook come la creazione di “un’infrastruttura sociale per dare alle persone il potere di costruire una comunità globale che funzioni per tutti noi”, ma nei documenti di ricerca interni i suoi dipendenti sottolineano che le comunità non sono sempre positive per la società: “Quando fanno parte di una comunità, gli individui agiscono tipicamente in maniera prosociale. Si conformano, stringono alleanze, cooperano, si organizzano, mostrano lealtà, si aspettano obbedienza, condividono informazioni, influenzano gli altri e così via. Essere in un gruppo cambia il loro comportamento, le loro abilità e, soprattutto, la loro capacità di danneggiare sé stessi o gli altri... Pertanto, quando le persone si uniscono e formano una comunità attorno a temi o identità lesive, il potenziale di danno può essere maggiore”.

Le scelte infrastrutturali che Facebook sta facendo per mantenere la sua piattaforma rilevante stanno abbassando la sua qualità ed esponendo i suoi utenti a più pericoli. Questi pericoli sono anche distribuiti in modo non uniforme, a causa del modo in cui determinate sottopopolazioni vengono guidate dall’algoritmo verso gruppi che la pensano allo stesso modo. E anche le sottopopolazioni di utenti di Facebook che sono più esposte a contenuti pericolosi hanno maggiori probabilità di trovarsi in gruppi in cui non verranno segnalati.

Molti dipendenti di Facebook credono che la loro azienda stia danneggiando le persone. Molti lo credono da anni. E nemmeno loro possono fermarlo. “Non possiamo fingere di non vedere i modelli di consumo delle informazioni e quanto siano profondamente dannosi per la longevità del discorso democratico”, ha scritto un ricercatore nel campo dello user-experience in un thread di commento interno nel 2019, in risposta a un memo oggi noto di Andrew “Boz” Bosworth, un dirigente di Facebook di lunga data. “Non esiste una posizione neutrale in questa fase, sarebbe fortemente immorale impegnarsi nell’amoralità”.

Nei mesi successivi al 6 gennaio, Mark Zuckerberg ha sottolineato la volontà di Facebook di aiutare gli investigatori federali. “Credo che l’ex presidente dovrebbe essere responsabile delle sue parole, e le persone che hanno infranto la legge dovrebbero essere responsabili delle loro azioni”, ha detto Zuckerberg in una testimonianza al Congresso la scorsa primavera. “Quindi rimane la questione dell’ecosistema informativo in senso più ampio. Ora, non posso parlare per tutti gli altri: le tv, le radio, i notiziari, i siti web e altre app. Ma posso dirvi cosa abbiamo fatto noi. Prima del 6 gennaio, abbiamo collaborato con le forze dell’ordine per identificare e affrontare le minacce. Durante e dopo l’attacco, abbiamo fornito ampio supporto nell’identificazione dei rivoltosi e abbiamo rimosso i post a sostegno della violenza. Non abbiamo trovato tutto, ma abbiamo reso i nostri servizi inospitali per coloro che potrebbero fare del male”.

Il modo in cui Zuckerberg ha posizionato il ruolo di Facebook nell’insurrezione è strano. Mette la sua azienda assieme alle organizzazioni dei media tradizionali, cosa che di solito è riluttante a fare, per timore che la piattaforma si assuma maggiori responsabilità per la qualità dei contenuti che vi vengono pubblicati e suggerisce che Facebook ha fatto di più, e ha fatto meglio, del giornalismo nella sua risposta al 6 gennaio. Quello che non riesce a dire è che i giornali non sarebbero mai in grado di aiutare gli investigatori in questo modo, perché i rivoltosi di solito non usano giornali e riviste per reclutare persone per i colpi di stato. Col senno di poi, è facile dire che Facebook avrebbe dovuto fare di più contro i rivoltosi prima che portassero a termine il loro attacco. Ma le persone pubblicano sempre post appassionati su proteste legittime. Come fa Facebook a sapere quali proteste si trasformeranno in violenza e quali no? La risposta qui è semplice: perché i suoi dipendenti hanno studiato ossessivamente questa domanda e sono sicuri di aver già trovato il modo per rendere Facebook più sicuro.

Facebook vuole che le persone credano che il pubblico debba scegliere tra Facebook così com’è, da un lato, e la libertà di parola, dall’altro. Questa è una scelta falsa. Facebook ha una comprensione sofisticata delle misure che potrebbe adottare per rendere la sua piattaforma più sicura senza ricorrere a tattiche di censura ampie o ideologicamente guidate. Facebook sa che non esistono due persone che vedono la stessa versione della piattaforma e che alcune sottopopolazioni sperimentano versioni molto più pericolose di altre. Facebook sa che le persone sole, per esempio vedove o divorziate di recente, o geograficamente lontane dai propri cari, corrono un rischio sproporzionato di essere esposte sulla piattaforma a contenuti dannosi. Sa che i recidivi sono responsabili in modo sproporzionato della diffusione di disinformazione. E sa che il 3 per cento degli utenti di Facebook negli Stati Uniti sono superconsumatori di teorie del complotto, e rappresentano il 37 per cento del consumo noto di disinformazione sulla piattaforma.

Il contenuto più virale su Facebook è fondamentalmente intoccabile: alcuni sono così virali che anche abbassando la manopola di distribuzione del 90 per cento non intaccherebbe la sua capacità di rimbalzare su Internet (un portavoce di Facebook mi ha detto che sebbene la piattaforma a volte riduca la frequenza con cui le persone vedono i contenuti che sono stati condivisi da una catena di due o più persone, è riluttante ad applicare quella soluzione in modo più ampio: “Mentre abbiamo altri sistemi che riducono il contenuto che potrebbe violare le nostre norme specifiche, come l’incitamento all’odio o immagini di nudo, questo intervento riduce tutti i contenuti con la stessa forza. Dal momento che è così affilato e colpisce sia il discorso positivo e completamente benigno sia la retorica potenzialmente infiammatoria o violenta, lo usiamo con parsimonia”).

Facebook sa che ci sono attività dannose che si svolgono sulla piattaforma che non infrangono nessuna delle sue regole, incluso gran parte del coordinamento che ha portato al 6 gennaio. E sa che i suoi interventi toccano comunque solo una minuscola frazione dei contenuti di Facebook. Facebook sa che a volte viene utilizzato per facilitare la violenza sociale su larga scala. E sa di aver agito troppo lentamente per prevenire tale violenza in passato.

Facebook potrebbe vietare le ricondivisioni. Potrebbe applicare coerentemente le sue politiche indipendentemente dal potere politico di un utente. Potrebbe scegliere di ottimizzare la sua piattaforma per la sicurezza e la qualità piuttosto che per la crescita. Potrebbe modificare il suo algoritmo per prevenire la distribuzione diffusa di contenuti dannosi. Facebook potrebbe creare una schermata trasparente in modo che tutti i suoi utenti possano vedere cosa sta diventando virale in tempo reale. Potrebbe rendere pubbliche le sue regole sulla frequenza con cui i gruppi possono postare e sulla velocità con cui possono crescere. Potrebbe anche limitare automaticamente i gruppi quando crescono troppo velocemente e limitare il tasso di viralità per i contenuti che si diffondono troppo rapidamente.

Facebook potrebbe affidare l’onere della prova alle persone e alle comunità per dimostrare che sono bravi attori e considerare la loro azione come un privilegio, non un diritto. Facebook potrebbe dire che la sua piattaforma non è per tutti. Potrebbe mandare un avvertimento a coloro che vagano negli angoli più pericolosi di Facebook e a coloro che incontrano livelli sproporzionatamente elevati di contenuti dannosi. Potrebbe ritenere i suoi dipendenti responsabili del prevenire che utenti si imbattano in versioni troppo dannose della piattaforma, impedendo così l’esistenza di tali versioni. Potrebbe fare tutte queste cose. Ma non le fa.

Facebook non è certamente l’unica entità dannosa sul social web. L’estremismo prospera anche su altre piattaforme social, e molte di esse sono alimentate da algoritmi altrettanto opachi. Ultimamente, molti hanno discusso di quanto sia davvero nefasto Facebook. Un argomento è più o meno questo: gli algoritmi di Facebook non sono magici, il targeting degli annunci non è nemmeno così buono e la maggior parte delle persone non è così stupida. Tutto questo può essere vero, ma non dovrebbe essere rassicurante. Un algoritmo può essere solo un grosso mezzo stupido per raggiungere un fine, un modo goffo di manovrare una rete massiccia e dinamica verso un risultato desiderato. Ma le enormi dimensioni di Facebook gli conferiscono un potere tremendo e instabile. Facebook prende intere popolazioni di persone, le spinge verso il radicalismo e poi dirige i radicalizzati l’uno verso l’altro. Per chi si è trovato nell’angolo di “Stop the Steal” di Facebook a novembre e dicembre dello scorso anno, l’entusiasmo e il senso di solidarietà devono essere stati travolgenti ed emozionanti. Facebook aveva preso la realtà distorta e l’aveva distribuita su larga scala.

A volte ho paragonato Facebook a una Macchina dell’Apocalisse in quanto è tecnologicamente semplice e incredibilmente pericoloso: una scatola nera di sensori progettati per aspirare segnali ambientali e fornire una distruzione reciprocamente garantita. Quando l’azienda più potente del mondo possiede uno strumento per manipolare miliardi di persone, uno strumento che solo lei può controllare e che i suoi stessi dipendenti dicono essere gravemente guasto e pericoloso, dovremmo prenderne atto. La lezione è questa: devi rimanere vigile sui flussi di informazioni in cui nuoti, riflettere su come spendi la tua preziosa attenzione, non perdonare coloro che armano le tue emozioni e la tua cognizione per il proprio profitto e diffidare profondamente di qualsiasi scenario in cui sei circondato da una folla di persone d’accordo con tutto ciò che dici.

E la lezione per Facebook è che il pubblico sta iniziando a riconoscere che merita una visione molto più ampia di come viene progettato e impiegato il macchinario della piattaforma. In effetti, questo è l’unico modo per evitare ulteriori catastrofi. Senza vedere come funziona Facebook con una risoluzione migliore, in tempo reale, non saremo in grado di capire come rendere il social web compatibile con la democrazia.

©️ 2021 The Atlantic Monthly Group, Inc.

All rights reserved.

Distributed by Tribune Content Agency

L'editoriale del direttore

Gli autogol di Meloni su Ai e innovazione