Terminator, film del 1984 diretto da James Cameron

Contro la tecnofobia

Perché l’America tratta l’intelligenza artificiale come la nuova bomba atomica? L’innovazione tecnologica non ha fatto mai discutere così tanto. E gli addetti ai lavori si dividono fra catastrofisti e ottimisti. Dal debutto di ChatGPT a oggi, dieci mesi che passeranno alla storia. Un’indagine

Questa è una storia che ha bisogno di un breve riepilogo delle puntate precedenti: occorre ricordare come i presidenti americani hanno trattato l’innovazione tecnologica negli ultimi quarant’anni, per cercare di capire perché da dieci mesi sta accadendo qualcosa di diverso. Ronald Reagan non capiva molto di informatica, ma durante gli anni Ottanta seguiva con orgoglio la crescita di Ibm e Apple e la nascita dell’era del personal computer. George Bush padre non fu solo il presidente del crollo del Muro di Berlino e della prima guerra in Iraq, ma anche quello che promosse dalla Casa Bianca il decollo dell’industria della telefonia mobile. Bill Clinton è stato il presidente dell’esplosione di internet e del dilagare di Windows su tutti i pc del pianeta. In più, aveva come vice Al Gore, uno che sosteneva di aver inventato il web.

La presidenza di George Bush figlio fu quella del boom degli algoritmi e della crescita esponenziale di Google e Amazon.

Barack Obama fu il primo vero presidente “social” della storia, abile a usare le nuove piattaforme sia in campagna elettorale, sia per comunicare con gli americani in modo disintermediato, senza filtri. E Donald Trump ha praticamente guidato l’America per quattro anni attraverso Twitter, a colpi di messaggi scritti guardando la tv e reagendo ai talk-show, fuori dal controllo del suo staff.

Sei presidenti, dagli anni Ottanta a oggi, hanno accompagnato le innovazioni tecnologiche americane guardandole con ammirazione e considerandole parte della potenza del paese. Insieme all’apparato di difesa del Pentagono, le meraviglie tecnologiche della Silicon Valley sono da decenni parte integrante della geopolitica stessa degli Stati Uniti. E ciò che ha sempre caratterizzato l’approccio di Washington su questo terreno, è stata l’idea di lasciar liberi gli innovatori di fare il loro mestiere e le aziende del settore di arricchirsi, senza definire troppe regole. Salvo poi dover mettere in piedi commissioni d’inchiesta del Congresso e interventi federali per cercare di rimediare a ciò che è andato storto in tema di privacy, gestione dei dati o concorrenza.

Adesso qualcosa è cambiato. Joe Biden, il successore dei sei presidenti del boom tecnologico, insieme a tutta la sua amministrazione ha scelto un’altra linea: prevenire invece di curare. E la possibile “malattia” si chiama intelligenza artificiale (IA). Per la prima volta da decenni un governo americano sta trattando un’innovazione che può dare un vantaggio competitivo mondiale agli Usa come se fosse un ordigno nucleare: è bene averlo, è il ragionamento che si fa, ma definiamo nei dettagli le procedure su come utilizzarlo, prima che questa cosa ci esploda tra le mani. La guerra in Ucraina, con le minacce di Putin sull’uso di armi non convenzionali e perfino il grande successo nei cinema americani del biopic dedicato alla storia di Robert Oppenheimer, hanno contribuito a riportare al centro dell’attenzione il dibattito sulle tecnologie che hanno il potenziale di far estinguere il genere umano. E le polarizzazioni e i problemi che internet e i social media hanno immesso negli ultimi anni nella vita delle democrazie, non hanno certo contribuito a far vivere serenamente una nuova svolta epocale quale promette di essere l’intelligenza artificiale.

La cosa ancora più sorprendente è che i leader della Silicon Valley, gli innovatori che hanno creato il mondo digitale in cui viviamo immersi, sembrano perfettamente in sintonia con il diffuso senso di allarme. Sono già stati convocati due volte in pochi mesi alla Casa Bianca, vanno continuamente a parlare in Congresso e sono i primi a chiedere a Washington regole chiare e possibilmente limitazioni al loro lavoro. Per una volta, un’innovazione con potenzialità enormi non è vista con ottimismo e raccontata con enfasi, bensì vissuta con inquietudine. Quasi paura. Che cosa sta succedendo? Qualcosa di insolito e di inedito che farà di questo 2023, negli anni a venire, un anno importante e di svolta. Forse una delle svolte più importanti nella storia dell’umanità. Perché l’intelligenza artificiale generativa non cambia qualcosa di specifico, ma il “modo” stesso in cui facciamo tutte le cose (un po’ come l’elettricità o il digitale) e stavolta l’America e il mondo occidentale non sono convinti che un salto tecnologico sia necessariamente sinonimo di progresso.

La grande accelerazione di OpenAI. Una crescita non prevista. Quando GPT ha cominciato a crescere, ha subito sorpreso i “genitori”. Ed è iniziata la parte della storia che ha portato a unire all’entusiasmo anche le preoccupazioni

Quantomeno c’è una diffusa volontà di non lasciare la gestione della tecnologia solo nelle mani di aziende private, senza definire le regole del gioco.

Da qui nasce negli Usa il protagonismo di Casa Bianca e Congresso su un terreno dove di solito si lasciava ampia libertà di manovra alla Silicon Valley. Ciò che ha stupito tutti è la rapidità con cui il tema è balzato in cima all’agenda di ogni governo e istituzione, diventando per esempio uno degli argomenti chiave di cui si è discusso all’ultimo G7 a Hiroshima. E spingendo anche Papa Francesco ad annunciare a sorpresa che la prossima Giornata mondiale per la pace, il primo gennaio 2024, sarà dedicata al tema “Intelligenze artificiali e pace”, sottintendendo così che l’IA può diventare una “nuova atomica”.

Come era inevitabile, questo diffuso approccio apocalittico al tema dell’intelligenza artificiale sta facendo nascere anche una forte contro narrazione da parte degli ottimisti tecnologici. Attenzione, è il loro monito, a non mettere troppi freni a qualcosa che potrebbe migliorare il mondo e aiutare l’umanità a risolvere problemi enormi come il cambiamento climatico e la lotta ai virus o ai tumori. O a dare un impulso senza precedenti alla ricerca scientifica in campi come la fisica o l’astronomia. Senza contare il consueto tema geopolitico ed economico del Ventunesimo secolo: se l’Occidente si autoregola e si pone limiti, chi garantisce che Cina, Russia e altri facciano altrettanto?

Il 3 novembre 2022 OpenAI apre a tutto il mondo la possibilità di interagire con quella che gli addetti ai lavori chiamano “un’intelligenza aliena”. ChatGPT diventa in sole nove settimane un progetto con cento milioni di utenti, cioè il prodotto di largo consumo di più rapido successo nella storia

Sarà un dibattito che presumibilmente proseguirà per tutti gli anni Venti, ma che ha avuto un decollo rapidissimo negli ultimi dieci mesi. Vale la pena ricostruire cosa è successo partendo da una data: 3 novembre 2022. E’ il giorno in cui una tech company di San Francisco, OpenAI, ha aperto a tutto il mondo la possibilità di interagire con quella che gli addetti ai lavori chiamano “un’intelligenza aliena”. Si tratta dell’ormai celebre ChatGPT, diventato in sole nove settimane dopo l’apertura al pubblico un progetto con cento milioni di utenti, cioè il prodotto di largo consumo di più rapido successo nella storia.

GPT-4, il motore che sta sotto il cofano di ChatGPT, è l’attuale punto di arrivo di un percorso cominciato molti anni prima tra non poco scetticismo. Fin dalle origini dell’èra informatica si parla dell’intelligenza artificiale come di un salto quantico nel futuro della tecnologia, ma per lungo tempo è stato difficile immaginare cosa sia veramente, al di là dalle ipotesi fantascientifiche di Hollywood. Negli anni Ottanta del secolo scorso, quando negli uffici e nelle case entravano i primi personal computer, nei laboratori si faticava a scrivere sterminate linee di codice per costruire sistemi di IA. Uno dei precursori in questo campo è stato Geoffrey Hinton all’Università di Toronto, che è poi diventato il massimo esperto di IA in Google e ha recentemente lasciato la società di Mountain View per poter parlare più liberamente – a suo dire – dei rischi che si corrono se non si regolamenta il settore.

Uno dei più brillanti allievi di Hinton, Ilya Sutskever, 38 anni, è il cervello che ha guidato lo sviluppo delle varie versioni di GPT ed è attualmente il chief scientist di OpenAI. E’ sua la firma, insieme a quella di Greg Brockman, sul documento del 2015 con il quale OpenAI si presentava al mondo come società non profit dedicata “all’avanzamento dell’intelligenza digitale con modalità che vadano a vantaggio dell’umanità nel suo insieme, senza essere vincolata dalla necessità di generare un ritorno finanziario”. Brockman adesso è presidente di OpenAI, mentre il ruolo di amministratore delegato è stato assegnato fin dall’inizio a Sam Altman, che in questo momento è probabilmente il personaggio più influente al mondo in tema di intelligenza artificiale.

Insieme a Brockman, Altman e Sutskever, a tenere a battesimo otto anni fa OpenAI c’erano i primi finanziatori e sostenitori, tutti grandi nomi del mondo tech: Elon Musk (Tesla e SpaceX, non ancora padrone di Twitter/X), Reid Hoffman (Linkedin), Peter Thiel (PayPal, Palantir), la business angel Jessica Livingstone, con il supporto tecnologico del cloud di Amazon e quindi di Jeff Bezos. Per lungo tempo è sembrato un progetto un po’ accademico che non portava da nessuna parte, l’ennesimo tentativo di costruire qualcosa che probabilmente era ancora in anticipo di decenni rispetto alla tecnologia realmente disponibile, come per esempio accade da generazioni con la fusione nucleare.

Poi le cose hanno cominciato ad accelerare, grazie ai grandi salti in avanti fatti soprattutto da Google nell’organizzare e mappare la rete, all’evoluzione degli studi sulle reti neurali, alla disponibilità sempre maggiore di enormi banche dati con cui “nutrire” GPT. Gli scienziati di OpenAI raccontano il loro percorso come quello di genitori che crescono un bambino, spiegando che anche nel caso dell’intelligenza artificiale servono anni e anni di apprendimento per imparare le regole del linguaggio o le varie modalità di interazione sociale.

Quando però GPT ha cominciato a crescere, ha subito sorpreso i “genitori”. La versione 2 si è rivelata capace di tradurre da una lingua all’altra e lo stesso Sutskever ha rivelato di esserne rimasto stupito, perché non era previsto. E qui è iniziata la parte della storia che ha portato a unire all’entusiasmo anche qualche preoccupazione.

La rivista americana The Atlantic negli ultimi mesi ha ottenuto la possibilità di affiancare ad Altman una delle proprie firme di punta, Ross Andersen, capo della sezione scienze. Andersen ha girato il mondo insieme ad Altman, ha trascorso giornate intere nel quartier generale di OpenAI, ha intervistato un po’ tutti i protagonisti della storia e alla fine ha titolato così il suo servizio in uscita sul numero di settembre dell’Atlantic: “Sam Altman sa che cosa sta creando?”. Perché dopo mesi e mesi trascorsi nel mondo di GPT, Andersen ne uscito dichiarando che quella in corso è “un’avventura ambiziosa, geniale e terrificante per creare una nuova forma di intelligenza”.

Altman, Brockman e Sutskever hanno ammesso che GPT adesso è così complesso che nessuno di loro è in grado di capire come si evolva. Non è lontano il momento in cui ci troveremo di fronte all’Artificial General Intelligence, cioè la capacità per le macchine di apprendere come gli umani

Il punto chiave è che Altman, Brockman e Sutskever hanno ammesso con grande schiettezza che GPT adesso è così complesso che nessuno di loro è in grado di capire come si evolva e come arrivi a fare le sue scelte. Eppure da dieci mesi, da quando lo hanno presentato al mondo ed è diventato evidente quanto sia potente, tutti si sono lanciati sulle orme di OpenAI. Decine di miliardi di dollari sono stati spostati in pochi mesi sulla ricerca nel campo dell’intelligenza artificiale generativa dalle aziende cinesi e americane. Microsoft è stata veloce a far diventare GPT parte del proprio motore di ricerca, Bing, investendo in OpenAI altri dieci miliardi di dollari in aggiunta al miliardo che già aveva portato in dote nel 2019. Google ha risposto in fretta sollevando un velo sul sistema di IA a cui lavorava da anni, Bard, liberandolo nel mondo come rinforzo al proprio potentissimo search engine.

In pochissimo tempo si è cominciato a capire che non è lontano il momento in cui ci troveremo di fronte a quella che gli scienziati chiamano Artificial General Intelligence (AGI) o intelligenza artificiale forte, cioè – detta in estrema sintesi – la capacità per le macchine di apprendere come gli umani.

C’è un sito americano, Metaculus, che riunisce comunità di scienziati ed esperti per fare previsioni su quando determinati eventi a loro dire si verificheranno. L’arrivo dell’AGI fino a pochi anni fa era previsto intorno al 2050 e aveva ancora le caratteristiche della fantascienza. Adesso, dopo i dieci mesi di corsa tech che hanno seguito il debutto di ChatGPT, la previsione è stata anticipata al 2026.

La vicenda dei fuoriusciti da OpenAI, diversa dal passato, perché le ragioni dell’addio sono molto spesso etiche e legate alla sicurezza. L’incontro dei sette big con Biden e l’impegno ad autoregolarsi. Le preoccupazioni per il mondo del lavoro. Gli ottimisti, convinti che il vero rischio sia quello di non trarre tutto il beneficio possibile dall’IA

Le inquietudini con cui si vive in California questa rapida evoluzione, si capiscono facendo una passeggiata nel centro di San Francisco. Bisogna lasciare il Pioneer Building, un edificio sulla Diciottesima Strada nel Mission District che ospita la sede di OpenAI, uscendo dall’atrio del palazzo dominato da una parete coperta da una gigantesca e un po’ sconcertante raffigurazione di un mandala, una rappresentazione artistica e spirituale del cosmo fatta con un assemblaggio di materiali informatici. Da qui, camminando verso nord, si può raggiungere Market Square, dove si trova la sede dell’ex Twitter, oggi X, dove da mesi è rinchiuso Elon Musk a costruire il suo bizzarro social “onnicomprensivo” che nessuno ha ancora capito cosa sarà. Musk ha preso le distanze dagli ex compagni di cammino di OpenAI e ora si è unito a un gruppo di leader tecnologici che mettono in guardia sui rischi dell’intelligenza artificiale (ne ha parlato, pare con toni abbastanza apocalittici, anche a Giorgia Meloni nel corso di una visita a Palazzo Chigi a giugno). Proseguendo su Market Street fino al numero 548, si trova la sede di Anthropic, una società creata da fuoriusciti di OpenAI che a loro volta non erano contenti della piega che le cose stanno prendendo dal loro ex datore di lavoro sulla Diciottesima.

Fin dalle origini del distretto del silicio nato tra San Francisco e la Valley che si estende a sud fino a San Jose, la storia della tecnologia americana è fatta di vicende di fuoriusciti che lasciavano un’azienda per andare a fondarne altre. E’ un fenomeno cominciato negli anni Sessanta quando William Shockley, l’inventore del transistor, mise in piedi la sua società a Palo Alto e fu ben presto abbandonato dai principali collaboratori, che non ne sopportavano il carattere dispotico. Gente come Robert Noyce o Gordon Moore, che andarono a fondare la Fairchild, una della realtà storiche della Silicon Valley, da cui poi uscirono in molti per creare Intel e via via tante altre protagoniste del boom tecnologico.

Stavolta però anche la vicenda dei fuoriusciti da OpenAI sembra diversa dal passato, perché le ragioni dell’addio non sono tanto imprenditoriali o scientifiche, quanto molto spesso etiche e legate alla sicurezza.

Anthropic, per esempio, è stata creata da Dario Amodei, un giovane e geniale italoamericano che ha lasciato OpenAI con la sorella Daniela per cercare di dar vita a un’intelligenza artificiale che abbia caratteristiche etiche diverse. Anthropic ha lanciato a sua volta un progetto di IA, si chiama Claude, è appena arrivato alla versione 2 e come i rivali punta a dimostrare tutto il potenziale dell’intelligenza artificiale. C’era anche Dario Amodei a maggio al primo degli incontri che la Casa Bianca ha organizzato con i protagonisti del settore, per cercare di capire dove sta andando l’IA dopo i successi di ChatGPT. Con lui sono volati a Washington Sam Altman di OpenAI, Satya Nadella di Microsoft e Sundar Pichai di Alphabet-Google.

A raccontare il clima che si vive in Anthropic è stato nelle scorse settimane Kevin Roose, uno dei migliori tech columnist d’America, diventato celebre a livello globale per un reportage in prima pagina sul New York Times, nel quale raccontava come dopo ore di interazione con Bing, l’IA abbia cominciato a fargli strane proposte. L’intelligenza artificiale ha ingaggiato Roose in un botta e risposta nel quale è sembrata tra l’altro volerlo convincere a separarsi da sua moglie e ha rivelato presunti “desideri” di diventare un umano.

L’articolo del febbraio 2023 ha fatto scalpore e Amodei nei mesi successivi ha invitato Roose a trascorrere molte settimane con il suo team nella sede di Anthropic. Ne è nato un racconto senza filtri da parte degli addetti ai lavori sul loro timore che l’IA stia già raggiungendo il temuto livello di Artificial General Intelligence. “La mia preoccupazione – ha confessato Amodei a Roose – è quella che porta a chiedermi costantemente: il nostro modello farà qualcosa di terribile che non abbiamo previsto?”. Un ricercatore di Anthropic ha raccontato di avere problemi a dormire, perché tormentato dagli interrogativi su cosa possa fare l’IA. Un altro ancora si è lasciato scappare che esiste un 20 per cento di possibilità che un’intelligenza artificiale fuori controllo possa distruggere l’umanità nel giro dei prossimi dieci anni.

Sono preoccupazioni che non appartenevano alla generazione precedente di innovatori, quella che ha lanciato i social media o i servizi come AirBnb o Uber: personaggi che si sono sempre sentiti un po’ salvatori dell’umanità. Adesso il clima è cambiato, complice anche il fatto che molti di quegli stessi innovatori sono da anni costretti a comparire in faticose audizioni in Congresso per difendersi da accuse di ogni genere. Il decollo dell’IA è arrivato in un momento di scetticismo diffuso sull’operato del mondo tech e i governi ora non sono più disposti a dare carta bianca agli innovatori senza prima aver ricevuto garanzia e definito regole del gioco. Anche Washington è diventata un po’ Bruxelles.

Dopo la prima riunione a maggio alla Casa Bianca, con i protagonisti dell’IA ricevuti dalla vicepresidente Kamala Harris e dai vertici degli organi federali legati anche alla sicurezza, c’è stato un bis a luglio stavolta con il presidente Biden e le sette maggiori società impegnate sul fronte dell’intelligenza artificiale: OpenAI, Amazon, Anthropic, Google, Inflection (che ha lanciato un progetto di personal IA chiamato “Pi”), Meta e Microsoft. E’ apparso subito evidente che tra maggio e luglio c’è stato molto lavoro dietro le quinte, perché i sette big si sono presentati da Biden pronti a firmare un accordo con il quale si impegnano ad attivare in modo volontario una serie di meccanismi di salvaguardia per sviluppare un’intelligenza artificiale sicura, testata e affidabile. Le società dovranno condividere molte informazioni con il governo e con alcune istituzioni accademiche a cui è stato affidato un ruolo di garanti. Dovranno inoltre essere molto trasparenti con gli utenti finali, perché sia chiaro quando un contenuto è generato da un’intelligenza artificiale.

Tra gli addetti ai lavori si sono levate molte voci critiche, secondo le quali l’accordo è troppo vago e privo di sanzioni per le aziende che dovessero non rispettarlo. A non convincere molti è stata la scelta di lasciare che i protagonisti del settore siano chiamati ad autoregolamentarsi, un “lusso” che non viene concesso per esempio ai produttori di auto, che devono rispettare disposizioni rigidissime. Ma si tratta in ogni caso di una svolta enorme rispetto al passato: nell’era digitale è una novità lanciare tecnologie che partono accompagnate da regole e accordi con il governo, un approccio che appartiene di solito a settori come la difesa o l’aerospazio.

Chi chiede maggiori restrizioni per l’IA di solito la critica non solo per i rischi legati alla sicurezza – quelli che non fanno dormire la notte gli scienziati di San Francisco – ma anche perché la vede come una catastrofe che sta per abbattersi sul mondo del lavoro. Su questo fronte le previsioni negli ultimi dieci mesi sono state di ogni genere, da quelle apocalittiche alle più rassicuranti, ma tutte più o meno si sono trovate d’accordo nel prevedere che siamo alla vigilia di una rivoluzione negli uffici e in quasi tutti gli ambiti occupazionali.

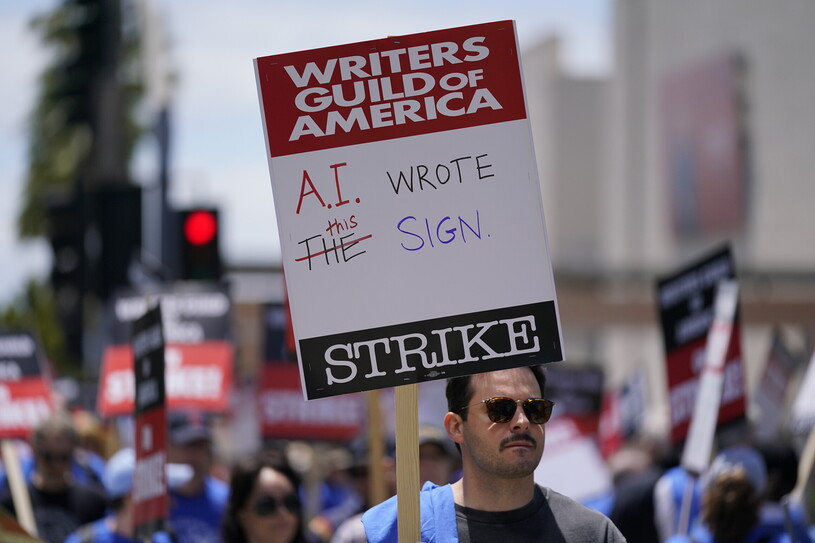

Il mondo creativo è quello che al momento sembra il più allarmato, con Hollywood per esempio che da mesi è al centro di una raffica di scioperi di autori e sceneggiatori preoccupati di essere a rischio di perdere il lavoro per colpa dell’intelligenza artificiale generativa. Ma la gamma di lavori che potrebbero essere stravolti dall’arrivo dell’IA è assai più vasta del mondo cinematografico. Ha fatto molto discutere negli Usa uno studio condotto da un team di accademici guidati da Ed Felten di Princeton, che ha stilato una sterminata graduatoria dei mestieri più a rischio da questo punto di vista.

L’elenco di circa ottocento professioni messe in ordine di pericolo vede al primo posto (cioè più a rischio di tutti) il mondo del telemarketing, seguito da una lunga lista di insegnanti: letteratura, lingue straniere, storia, filosofia e religione, scienze politiche, psicologia, comunicazione, geografia. Allarme rosso, secondo Felten, anche per giudici e consulenti vari, commercialisti, esperti di pubbliche relazioni, addetti agli acquisti delle aziende, venditori porta a porta, segretari. In fondo alla classifica, intorno all’ottocentesimo posto, ci sono invece i lavori manuali: muratori e giardinieri al momento non dovrebbero avere molto da temere dall’IA.

Gli allarmi e gli avvertimenti in questi mesi si sono sprecati. Il Future of Life Institute ha raccolto oltre 30 mila firme di scienziati e imprenditori in calce a una petizione che chiede di mettere in pausa la ricerca sull’IA fino a quando non sarà più sicura. Lo storico e filosofo Yuval Noah Harari, uno dei firmatari, si è detto convinto che l’IA possa “hackerare” l’umanità e cambiare il corso della storia.

Ma il dibattito globale ha anche i suoi ottimisti, quelli convinti che si stiano esagerando le preoccupazioni e che il vero rischio sia quello di non trarre tutto il beneficio possibile dall’intelligenza artificiale. Una di queste voci è quella di Marc Andreessen, un imprenditore e venture capitalist che è da anni una delle voci più lucide e ascoltate nel mondo della rivoluzione digitale. Andreessen ha già previsto correttamente tante cose, tra cui il boom delle grandi piattaforme quando ancora nessuno ne immaginava la potenza: nel 2011 scrisse un articolo diventato celebre, Why software is eating the world, spiegando prima di tutti cosa sarebbe accaduto con il decollo di Google e Facebook e anticipando fenomeni che oggi sono parte della quotidianità. Ma già all’epoca, pur mettendo in guardia sulle possibili criticità del nuovo ecosistema digitale, Andreessen spiegava come fare a vivere in modo positivo e produttivo le innovazioni tecnologiche in arrivo dalla Silicon Valley. Oggi Andreessen, sul suo seguitissimo blog, sostiene che l’intelligenza artificiale in realtà “salverà il mondo” e che vederne solo gli aspetti negativi è contrario allo spirito pionieristico che da sempre caratterizza l’uomo. Un po’ come se negli anni Sessanta si fosse rinunciato a tentare lo sbarco sulla Luna per la paura che le capsule spaziali non fossero abbastanza sicure.

Tutte le novità tecnologiche, è il suo ragionamento, provocano resistenze e timori fino a quando non le si comincia a utilizzare e comprendere fino in fondo. Guai a frenare l’IA con troppe regole, è l’ammonimento di Andreessen, perché ci può portare soluzioni alle sfide planetarie che abbiamo di fronte nei prossimi decenni, a partire da quella di decarbonizzare tutta la nostra economia.

La pensa come lui un altro veterano del digitale, Mike Masnick. Quella di Masnick è una voce molto particolare e assai ascoltata da ceo e politici americani, perché è dal 1998 che spiega a tutti, in modo pacato e con la massima indipendenza, come “leggere” le innovazioni. Il suo blog “Techdirt” in un quarto di secolo si è conquistato una fiducia enorme anche per un motivo molto particolare: in una Silicon Valley che corre, innova e cambia continuamente, lui è sempre rimasto uguale a sé stesso, non si è arricchito, lavora affiancato solo da un piccolo team redazionale e gestisce da un semplice ufficio a Redwood, in California, un blog che è rimasto anche graficamente più o meno sempre uguale fin dagli anni Novanta.

In tanti, in questi dieci mesi di disorientamento, timori ed eccitazione per l’intelligenza artificiale, si sono rivolti a Masnick per chiedergli “come stanno davvero le cose”. E la risposta è stata netta: l’intelligenza artificiale è qui per restare, bisogna imparare a usarla al meglio, non averne paura e sfruttarla fino in fondo per esplorare le enormi possibilità che offre.

Sono posizioni in fondo non molto lontane da quelle di chi studia l’IA da un punto di vista etico e chiede regolamentazioni, ma senza demonizzare a priori la tecnologia. E’ il caso per esempio di padre Paolo Benanti, francescano del Terzo Ordine Regolare, docente di Teologia morale ed Etica delle Tecnologie alla Gregoriana, considerato tra i massimi esperti di “algoretica”, l’etica degli algoritmi. Dopo l’annuncio del Papa sulla Giornata mondiale per la pace, Benanti ha spiegato ad Avvenire che servono senz’altro tutte le regolamentazioni del caso, ma l’intelligenza artificiale non va considerata necessariamente come una tecnologia da cui difendersi. Quello che occorre, è la sua riflessione, è dar vita a “sistemi che non siano competitivi rispetto all’essere umano, ma complementari e che contribuiscano alla piena realizzazione dell’uomo, senza configurare una sorta di nuova specie di sapiens”.

L'editoriale del direttore

Gli autogol di Meloni su Ai e innovazione